Deep Learning

世界的に爆発的に利用されて成果を挙げているDeep Learning.

いまやとりあえずDeep Learningでっていう傾向に嫌気がさすかもしれません.

大量にあるデータを長い時間をかけて学習させることにより、これまでの性能を遥かに凌ぐ識別能力があるという以上仕方のないことかもしれません.

Deep Learningは多層ニューラルネットワークと呼ばれる情報の入出力関係を機械に擬似的に用意して、

入力部分に何かデータを与えたら、出力から答えを出すブラックボックスを作る枠組みです.

そのときに大きく分けて、

大量のデータによる教師無し学習を行うPre-trainingと、

少量のデータによる教師あり学習を行うFine-tuningを実行します.

教師無し学習というのは、例えていうなら何の画像かも教えずに被験者に見せ続けることをさします.

一方で教師あり学習は、猫の画像です、犬の画像です、と画像に現れる特徴について明言をします.

Deep Learningは、これらの学習の連携により、何が映った画像なのかというのを自動的に高精度に識別する能力を機械に宿すことが出来るというものです.

それではDeep Learningのどのような性質が効いて、その驚異的な性能を示しているのでしょうか.

実際に行われていることそのものを理論的に調べるのは大変ですから、ひとつひとつ切り出すことによって

考えて行く地道な研究を、統計力学と呼ばれる物理学の手法を用いることで始めました.

まずは教師無し学習と教師あり学習の組み合わせを行うと、どのように性能があがるのかについて焦点を当てて調べることに成功しました.

教師無し学習であっても、データに構造がある場合は、少しずつデータを入力することで識別性能が徐々に引き上がることが分かりました.しかしDeep Learningのように大量のデータをとにかく入力していくと、ある日突然賢くなる現象を発見しました.

学習の一次相転移です.

Fine tuningによって、その一次転移を比較的早く起こさせることもわかります.

Deep Learningは非常に多くのデータから少しずつ学習をして着実に学習を進めている努力家さんなんだということがわかります.

参考文献

M. Ohzeki: J. Phys. Soc. Jpn., 84, 034003 (2015)

Semi-supervised learning

いくつかのグループに分けられたデータがあるとしよう.そのデータを見れば、それぞれのグループの特徴がわかってくる.

学習の成果である.未分類のデータが与えられたとしても、その学習の程度がよければ高精度で分類することが可能となる.

その学習に未分類のデータが使えるだろうか.

データ取得技術の向上により大量のデータが利用可能となった現代.

データの分類や特徴を明らかにするために時間やコストがかかる場合、大量の未分類データと、分類済みの少量のデータの両者を利用する他ない.これを半教師あり学習と呼ぶ.

この半教師あり学習の研究において、ひとつのテーマとして未分類データの有効性の検証が重要となってくる.

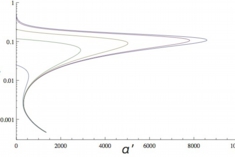

図は横軸に未分類だけど学習に利用した問題数.縦軸に未知のデータの分類の誤り率を示している.異なる曲線はあらかじめ与えられた分類済みのデータの個数(左下に行くほど多め)である.最近我々の研究グループでは、非常に大量の未分類データを利用すると、学習した分類器の性能が飛躍的に向上する相転移現象を発見した.この相転移現象の解析にはやはりスピングラス理論が利用されており、学際的にも興味深い問題である.

図は横軸に未分類だけど学習に利用した問題数.縦軸に未知のデータの分類の誤り率を示している.異なる曲線はあらかじめ与えられた分類済みのデータの個数(左下に行くほど多め)である.最近我々の研究グループでは、非常に大量の未分類データを利用すると、学習した分類器の性能が飛躍的に向上する相転移現象を発見した.この相転移現象の解析にはやはりスピングラス理論が利用されており、学際的にも興味深い問題である.

他にもクラスタリングと呼ばれる、未分類のデータをいくつかのグループ分けにするための手法を統計力学を出発点として開発している.

参考文献

M. Ohzeki and T. Tanaka: to be submitted

Sparse inverse problem

多くのデータが生成される昨今、その背後にある構造を明らかにすることで、本質をつかむこと、実際の説明変数を縮約しようとする試みがある.その構造が多少なりとも事前に分かることがあればそれを利用することで、その本質をつかむことが容易になることがある.

たとえば学生がカンニングをしている、それを探したいとする.

でも先生が学生一人一人を問いつめるわけにはいかないとしよう.

答案が何枚も送られて、その採点途中、カンニングを知ることは実際の先生であれば容易い.

それは事前にどの学生が普段は成績の向上が認められない、授業の参加態度が芳しくないなどの情報があるからだ.

純粋に答案からカンニングを推測することはなかなかに難しい.

しかしながらカンニングはそんなに多くないだろうという誰しもが納得する事前情報を入れ籠んだ確率推論を利用することで、

カンニングの検出が効率よく精度良く行うことが出来る.

もちろん話はカンニングに限らない.広く逆問題を扱うことが出来るため、今後の広い応用が期待される.

参考文献

S. Yamanaka, M. Ohzeki and A. Decelle: J. Phys. Soc. Jpn. 84, 024801 (2015)

M. Ohzeki: to be submitted to JPSJ

M. Ohzeki and U. Yamamoto: to be submitted to JPSJ

報道

朝日新聞大阪本社版(34面社会2)

朝日デジタル版(![]() 人工知能でカンニングを発見 京大などがプログラム開発)

人工知能でカンニングを発見 京大などがプログラム開発)

NHKおはよう日本「カンニング対策ー人工知能で見破る研究も」(3月27日放送)

TBSテレビあさチャン!「人工知能使いカンニングを発見」(1月19日放送)

Partial response channel

皆さんの身近にあるHDDやSSDに記録された情報の読み出しはどのようにして行われているだろうか.

実は情報の読み出しを行う際には、ノイズの存在や、高度集積化の結果生じる隣接する情報要素間の干渉など様々な要因がその正しい読み出しを阻害している.このような要素を排除しながら、原情報を推定しなければならない.

このような情報の読み出し過程を表現した数理模型をPartial Response channelと呼ぶことがある.

この数理模型に基づき、原情報の推定問題を定式化すると、統計力学で現れるスピングラス模型と等価であることを示すことが出来る.スピングラス模型の解析手法や数値計算手法に基づいて、精度のよい推定方法を提案することが可能となる.

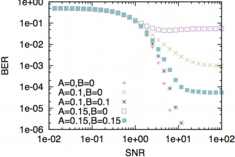

図は横軸にSNR(シグナルとノイズの強度比で大きくなるほどシグナル強度が大きい)縦軸に推定の結果エラーがどの程度残っているかを示している.

図は横軸にSNR(シグナルとノイズの強度比で大きくなるほどシグナル強度が大きい)縦軸に推定の結果エラーがどの程度残っているかを示している.

ノイズなどの不確実な要素を排するために確率的な推定が必要である一方、特に干渉効果によるものは事前の知識を盛り込むことで有効的に排除することが可能であり、どのように組み込むかの戦略をスピングラスの知見から得ることが出来る.

干渉の強度Aが大きくなるにつれて、エラーが残るようになるが、それに対して干渉効果にあわせて調整された推定のパラメータBをあわせるように変化させると精度の良い推定が可能となっていることがわかる.

Compressed sensing

ある原情報を取り出すために観測するときにコストなどの問題で、その原情報を取り出すために観測数が足りない状況を考える.

この足りない部分を引き出すために、取り出したい原情報に見合った事前知識を使おう.

特にその原情報が実はスパースであり、うまく狙い撃ちすれば少ない観測でも事足りた場合に有効なのが圧縮センシングである.

もちろん事前にはその狙い撃ちするべき場所はわからない.

実験屋が観測を出来るだけがんばって得た観測データから、事前知識を盛り込んだ確率的推論の技術により、原情報を再構成することが出来る.

我々のグループでは医療画像や物性評価のためのX線・中性子散乱データなどからこれまでに得られなかった高精度の原情報再構成に取り組んでいる.

(京大医学部・同志社大学・東北大学AIMR等との共同研究中)